di Michele Ainis*

Il dibattito ha fornito molte indicazioni sui principi che guidano l’Autorità Antitrust nell’applicazione delle norme a tutela della concorrenza e del consumatore nel contesto dell’economia digitale. Ed è stato utile ricordare alcuni interventi assunti dall’Autorità di recente. Come hanno avuto modo di osservare i vari oratori, l’Autorità ha strumenti adeguati anche di fronte ai nuovi fenomeni determinati dall’innovazione digitale.

Il dibattito ha fornito molte indicazioni sui principi che guidano l’Autorità Antitrust nell’applicazione delle norme a tutela della concorrenza e del consumatore nel contesto dell’economia digitale. Ed è stato utile ricordare alcuni interventi assunti dall’Autorità di recente. Come hanno avuto modo di osservare i vari oratori, l’Autorità ha strumenti adeguati anche di fronte ai nuovi fenomeni determinati dall’innovazione digitale.

Non è necessaria la revisione del cosiddetto “tool-box” per affrontare le sfide poste dall’innovazione digitale; si tratta piuttosto di realizzare un ripensamento delle modalità con le quali applicare gli strumenti tradizionali dell’analisi a un contesto fortemente mutato. D’altronde le norme europee a tutela della concorrenza (e quindi quelle italiane) hanno mostrato di possedere una felice caratteristica: una formulazione ampia, che le rende flessibili ad adattarsi alla mutevolezza del contesto al quale vengono applicate.

L’innovazione introdotta da Internet comporta molte opportunità, però implica anche rischi, per i consumatori e per le imprese. L’economia digitale ha permesso scambi, transazioni un tempo impensabili in termini di rapidità e mole dei dati scambiati. E’ oggi possibile l’incontro tra agenti economici che prima non si sarebbero mai incontrati, se non sostenendo costi di transazione elevatissimi. I social media consentono la comunicazione e lo scambio di idee in tempo reale, tra tutti gli individui. Ma proprio su questo punto è opportuna una riflessione. Ed è diventato urgente riflettere sulla profilazione di cui si è parlato questa mattina.

Come ha ricordato il Presidente dell’ Antitrust Pitruzzella , si tratta di un fenomeno che può avere un impatto diverso, a seconda che coinvolga l’individuo nella sua veste di consumatore o di cittadino. E allora provo a declinarne gli effetti su entrambe le categorie. Il cittadino La libertà di manifestazione del pensiero rappresenta la «pietra angolare» della democrazia, dichiara una celebre sentenza della Corte Costituzionale, vergata nel 1969. Ma ormai non più: oggi, la questione dirimente non è di garantire la circolazione delle idee, bensì la loro formazione, la loro genuina concezione. Se in apparenza i social media consentono a chiunque di esprimersi liberamente e di confrontare le proprie idee, potenzialmente con chiunque, gli stessi strumenti digitali possono in realtà restringere il confronto libero di idee.

Come ha ricordato il Presidente dell’ Antitrust Pitruzzella , si tratta di un fenomeno che può avere un impatto diverso, a seconda che coinvolga l’individuo nella sua veste di consumatore o di cittadino. E allora provo a declinarne gli effetti su entrambe le categorie. Il cittadino La libertà di manifestazione del pensiero rappresenta la «pietra angolare» della democrazia, dichiara una celebre sentenza della Corte Costituzionale, vergata nel 1969. Ma ormai non più: oggi, la questione dirimente non è di garantire la circolazione delle idee, bensì la loro formazione, la loro genuina concezione. Se in apparenza i social media consentono a chiunque di esprimersi liberamente e di confrontare le proprie idee, potenzialmente con chiunque, gli stessi strumenti digitali possono in realtà restringere il confronto libero di idee.

Pensiamo di pensare, ma in realtà ripetiamo come pappagalli i pensieri altrui. O al limite anche i nostri, però amplificati e deformati, senza verifiche, senza alcun confronto con le opinioni avverse. È l’universo autistico in cui siamo rinchiusi, anche se per lo più non ci facciamo caso. Un universo tolemaico, in cui il sole gira attorno alla terra – ed è ognuno di noi, la terra. Succede perché, quando navighiamo online, siamo esposti ad informazioni “filtrate”.

Tutto ha avuto inizio il 4 dicembre 2009, quando Google avvertì i propri utenti che da allora in poi avrebbe personalizzato il proprio motore di ricerca. Significa che i risultati cambiano a seconda delle ricerche precedenti, del computer da cui stiamo interrogando Google, del luogo nel quale ci troviamo. In breve, significa che se due tifosi della Juve e della Roma – per esempio – digitano «calcio», otterranno pagine diverse, sia nel numero sia nella gerarchia delle notizie. Più che una riforma, una rivoluzione, come per primo s’incaricò di segnalare un libro divenuto cult (Eli Pariser, The Filter Bubble, 2011).

E la rivoluzione si propagò immediatamente agli altri giganti della Rete, da Apple a Microsoft, da Amazon a Facebook, a Twitter, a WhatsApp. È, per l’appunto, la «profilazione» dell’utente, un nuovo strumento che affila le tecniche di marketing, le rende sempre più sofisticate. D’altronde, grazie ai dispositivi mobili, non è più necessario interrogare i motori di ricerca, perché loro ti rispondono senza lasciarti il tempo di formulare la domanda.

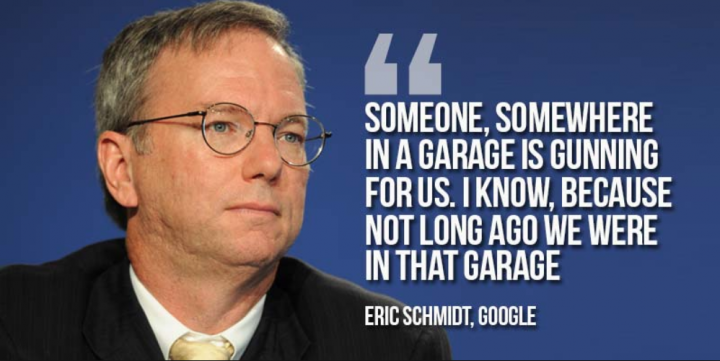

Si è così realizzata la visione di cui parlava nel 2010 Eric Schmidt, amministratore delegato di Google: “Immagina di star camminando per strada. A causa di tutte le informazioni che Google ha raccolto su di te, noi sappiamo chi sei, a cosa sei interessato, chi sono i tuoi amici. Google sa, con l’approssimazione di pochi centimetri, dove ti trovi. Se hai bisogno di latte, e se c’è un negozio che lo vende lì vicino, Google te lo segnalerà“. Noi non sappiamo quali informazioni personali detengano i signori della Rete, né tantomeno conosciamo le concrete modalità di rielaborazione e circolazione delle stesse. O meglio, formalmente ci viene richiesto di esprimere un consenso al trattamento dei nostri dati, ma non siamo mediamente in grado di conoscere esattamente la natura e la mole dei dati che forniamo alle piattaforme digitali in cambio dei servizi resi da queste ultime senza il pagamento di un prezzo monetario.

Sappiamo che Google usa 57 indicatori per profilarci dalla testa ai piedi. Sappiamo che Netflix ospita la più grande banca dati al mondo, quanto alle preferenze dei consumatori in materia di fiction cinematografica e televisiva. Sappiamo che cercando una parola come «depressione» su un dizionario online, il sito installa fino a 223 cookies nel nostro computer. Sicché mentre navighiamo online i nostri gusti, le nostre opinioni, le nostre frequentazioni telematiche vengono registrate. Tale moltitudine informe di dati viene elaborata in modo da estrarne il valore economico. Veniamo “incasellati” in base alle nostre preferenze che vengono cedute agli inserzionisti, i quali possono così inseguirci con una pubblicità tagliata su misura. Ma insieme al filtro delle comunicazioni commerciali ci viene applicato anche un filtro sulle preferenze politiche, etiche, religiose, con il rischio di essere esposti esclusivamente ad informazioni a noi note. L’autismo digitale.

Dunque le tecniche di profilazione non chiamano in causa unicamente i nuovi business o la vecchia privacy. Mettono in gioco la possibilità di rapportarci gli uni agli altri, d’aprirci al mondo esterno. Così come l’algoritmo di Amazon ci suggerisce libri simili a quelli che stiamo consultando, al contempo i filtri che agiscono sul web tendono a proporci all’infinito le stesse fonti da cui già ci siamo alimentati, le stesse opinioni, le stesse informazioni. Sembrerebbe un sistema di induzione e controllo del “bisogno”. La progressiva “chiusura” delle idee in un recinto ben definito consente la semplificazione dell’offerta di beni e servizi: tanto più le preferenze di consumo sono omologate, tanto più semplice il business di chi deve soddisfare tali preferenze.

Le informazioni circolano, ma a compartimenti stagni, in circuiti separati. Da qui il confirmation bias, ovvero l’influenza delle nostre aspettative sui fatti rispetto al modo con cui li interpretiamo: uno schema mentale antico quanto l’uomo, che però l’informatica eleva alla massima potenza. Da qui, ancora, il fenomeno della post-truth, che Oxford dictionaries ha scelto come parola dell’anno 2016. In questo caso la “postverità” esprime l’irrilevanza dei fatti nella formazione dei processi cognitivi, come la negazione del riscaldamento globale o le false informazioni che hanno determinato Brexit (per esempio circa i costi pagati dagli inglesi all’Unione europea: 350 milioni di sterline a settimana, una cifra mai documentata).

Da qui, infine, una neonata disciplina: l’agnotologia, battezzata da Robert Proctor per indicare lo studio dell’ignoranza indotta attraverso dati scientifici fuorvianti. Ma l’agnotologia è nemica della democrazia, dato che quest’ultima si nutre del confronto tra punti di vista eterogenei. Il consumatore I dati personali che forniamo rappresentano la moneta con la quale paghiamo ogni chat, ogni ricerca, ogni consultazione online. Accettando i cookies, inoltre, rinunziamo alla segretezza delle nostre informazioni, ma forse senza la dovuta consapevolezza. Il compito dell’Autorità Antitrust, insieme alle consorelle Privacy e Agcom, è quello di individuare il limite tra legittimo “prelievo” e utilizzo dei dati dell’utente, e illegittima raccolta o sfruttamento degli stessi.

Da qui, infine, una neonata disciplina: l’agnotologia, battezzata da Robert Proctor per indicare lo studio dell’ignoranza indotta attraverso dati scientifici fuorvianti. Ma l’agnotologia è nemica della democrazia, dato che quest’ultima si nutre del confronto tra punti di vista eterogenei. Il consumatore I dati personali che forniamo rappresentano la moneta con la quale paghiamo ogni chat, ogni ricerca, ogni consultazione online. Accettando i cookies, inoltre, rinunziamo alla segretezza delle nostre informazioni, ma forse senza la dovuta consapevolezza. Il compito dell’Autorità Antitrust, insieme alle consorelle Privacy e Agcom, è quello di individuare il limite tra legittimo “prelievo” e utilizzo dei dati dell’utente, e illegittima raccolta o sfruttamento degli stessi.

Un compito non semplice, perché se da un lato la tutela del consumatore protegge la consapevolezza dell’utente sull’utilizzo dei propri dati, dall’altro l’Autorità non può ignorare che la cessione di quei dati soddisfa un interesse economico dell’utente, consentendogli la fruizione “gratuita” di servizi ai quali è interessato. Inoltre, quei dati sono “benzina” (o “petrolio” secondo l’Economist) di innovazione, poiché consentono il miglioramento dei servizi offerti e la fornitura di nuovi. Il tema del “prelievo”, con specifico riguardo alla consapevolezza del consumatore sui propri dati ceduti online, è all’attenzione dell’Autorità, come testimoniato anche dai recenti interventi in materia (Facebook/Whatsapp e Samsung – PS10207). Difatti, non sempre l’utente di una piattaforma online o di un social media ha chiaro quali e quanti dati cede in cambio del servizio che ottiene, né tantomeno possiede gli elementi per valutare la natura proporzionata dello scambio.

Tu dai il consenso per una radiografia, loro ti somministrano una tac. Sul fronte delle ricadute concorrenziali l’analisi è certamente più delicata. Perché, come abbiamo ascoltato questa mattina, sono molti i fattori – a volte nuovi – da esaminare prima di poter ipotizzare una violazione dei principi a tutela della concorrenza da parte delle imprese in materia di raccolta/trattamento/vendita dei dati degli utenti. Occorre delimitare correttamente il perimetro concorrenziale in cui si muovono le imprese (si tratta di mercati relativamente nuovi), comprendere l’effettivo potere di mercato dei grandi operatori online, esaminare l’esistenza di barriere alla raccolta dei dati degli utenti, la diversa qualità e quindi il diverso valore economico del dato.

Si può ritenere, infatti, che lo sfruttamento commerciale del dato dipenda anche dalla sua diretta connessione con le preferenze di consumo e così, nella moltitudine di dati ceduti, solo alcuni avranno un valore elevato sul mercato della raccolta pubblicitaria. Ancora, bisogna tenere in debito conto il fatto che la “moneta” che l’utente utilizza per “pagare”, i propri dati, il più delle volte corrisponde a informazioni che lo stesso utente non ha modo di sfruttare economicamente in modo alternativo. In altre parole, i dati ceduti non hanno un valore economico in senso stretto per l’utente medio e sono peraltro spendibili contemporaneamente su più fronti (multi-homing, portabilità ecc).

Infine, ma non ultimo, l’Autorità esamina i comportamenti delle imprese nel settore digitale con particolare attenzione alle possibili ricadute in termini di incentivi all’investimento, nella convinzione che, nonostante tutti i limiti evidenziati nel dibattito odierno, lo sviluppo digitale degli ultimi vent’anni abbia prodotto una crescita delle opportunità senza pari nella storia, nonché rilevantissimi incrementi di efficienza. Questo non esclude, d’altra parte, che l’intervento antitrust sia opportuno laddove i comportamenti delle imprese si traducano in condizioni inique per i propri clienti o in una concorrenza non giocata sul merito. Anche perché lo sviluppo digitale rischia di subire battute d’arresto se gli attori principali (i consumatori: che forniscono dati, effettuano ricerche, convivono sui social e realizzano transazioni online) iniziano a maturare sentimenti di sfiducia quando navigano sul web (come rilevato anche dalla Commissaria alla concorrenza Vestaeger) .

L’Autorità si ispira ai principi della concorrenza delineati dalla normativa europea e trasfusi in quella nazionale, nei quali trova spazio il concetto di equità. In questo senso si è espressa un paio di settimane fa anche la Commissione europea, nelle parole del Direttore Generale per la Concorrenza, Laitenberger. L’equità delle condizioni imposte dalle imprese con riferimento ai dati raccolti dai propri utenti può ben rappresentare un terreno di indagine per un’autorità di concorrenza, laddove sia possibile rinvenire le condizioni per riconoscere in capo all’impresa una posizione dominante nel mercato.

In questo solco è stata avviata un’indagine conoscitiva congiunta con il Garante della Privacy e con l’AGCom sui big data, al fine di affinare la comprensione del fenomeno. In questo contesto, possono assumere un ruolo decisivo gli algoritmi utilizzati dalle piattaforme online per l’elaborazione dei dati provenienti dall’utente. Tali algoritmi consentono alle imprese la massimizzazione del profitto attraverso una rapidissima elaborazione di informazioni disponibili online sulle condizioni praticate dai concorrenti, e il conseguente adattamento delle proprie strategie di prezzo. Il fenomeno del machine learning (la modalità di autoapprendimento dei software basata sull’elaborazione progressiva, rapida e continua dei dati esistenti) non esclude che l’ottimizzazione della strategia di prezzo conduca il singolo programma ad interagire con gli altri.

L’OCSE ha diffusamente analizzato le potenzialità collusive insite nell’utilizzo di software e algoritmi da parte di imprese operanti nella fornitura dei medesimi servizi. Ma anche questa linea di intervento richiede cautele. In primo luogo, per gli effetti positivi in termini di efficienza che l’impiego di tali software determina sia dal lato dell’offerta (riduzione dei costi di produzione) sia dal lato della domanda (permettendo una discriminazione di prezzo basata sulla disponibilità a pagare dell’utente). In secondo luogo, nella misura in cui l’interazione avviene attraverso un programma, può perdersi l’elemento umano dell’intento collusivo, dell’”incontro di volontà” richiesto dalla normativa antitrust. In conclusione, l’Autorità è attenta agli sviluppi dei mercati digitali e ai fenomeni connessi.

Teniamo gli occhi aperti, ma anche voi, la stampa, aiutateci a guardare.

*Michele Ainis è un giurista e costituzionalista italiano. editorialista del quotidiano La Repubblica, Dall’8 marzo 2016 è componente dell’AGCM, Autorità garante della concorrenza e del mercato